[잡담] 미래에셋증권: AI 서버에서 메모리 비용 구조 추정

강남토박이

조회 : 1,155

강남토박이

조회 : 1,155

AI 서버 비용 Guestimation

- 결론: HBM의 가격과 MU의 M/S 고려하면 국내사에 크게 불리하지 않음

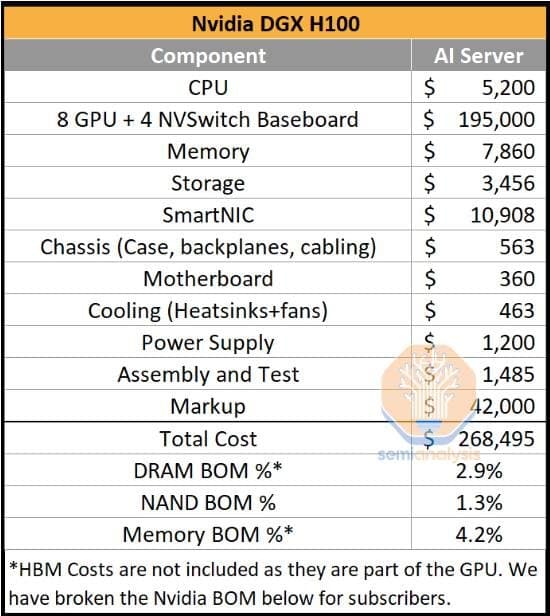

- 상기 기사의 요지는 DGX Server 에서의 DRAM BOM 비중이 낮기에, Micron이 가장 열위에 있다는 내용입니다.

"Micron looks very weak in AI"

- GPU에 부착된 HBM을 제외한 DRAM의 BOM Cost는 $7,860(2.9%)

- HBM2E의 경우 12달러/GB, HBM3의 경우 14달러/GB

- H100의 경우 HBM 80GB를 기본으로 장착

- DGX H100에서의 HBM Cost = 8GPU x 80GB HBM x 14달러/GB = $8,960

- DGX H100의 Total DRAM = HBM + DRAM = $16,820 = 6.3% of BOM

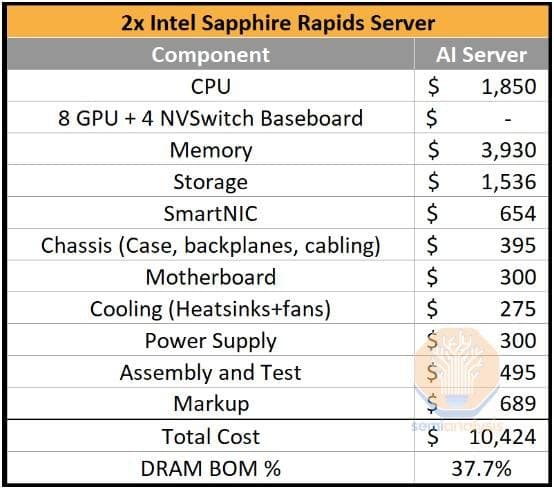

- Sapphire Rapids Server에서의 DRAM BOM = $3,930 과 비교하면 약 4배가량의 DRAM Cost 소모

- 기존 Server DRAM에서의 시장점유율 SK하이닉스 39%, 삼성전자 35%, Micron 25%과 달리

- HBM에서의 23F 시장점유율은 SK하이닉스 48%, 삼성전자 43%, Micron 9% 까지 고려하면

- Sapphire Rapids Server에서의 삼성전자+SKH Share = $3,930 x 81% = $3,183

- DGX에서의 삼성전자+SKH Share = $16,820 x 91% = $15,360으로 5배 이상의 Effect 有

- DGX Server의 가격이 기존 Server 대비 약 27배 비싼데, 단순 호환 관계는 아니지만 다른 변수를 통일한 가정하에,

- Service Provider 입장에서 DGX 한개를 투자하느라 Capex가 부담되어 Sapphire Rapids server 구매를 1/5로 줄이지 않는 이상

국내 DRAM사에 유리한 환경

감사합니다.